ファクトチェックで、AIが「根拠なし」と断言した

「これ、根拠がありませんね」

AIにそう言われて、一瞬固まった。いや、厚生労働省のURL、貼ってあるんだけど…。

Apple Watchのムーブゴールについて書いた記事。厚生労働省の資料を引用し、数値を表にまとめた。URLも貼り、出典元も明記している。念の為、AIに整合性と正確性のファクトチェックを依頼した。

AIの返答は予想外だった。

「身体活動量が総エネルギー消費の30%という根拠が見当たりません」

えっ?厚生労働省の資料って記事に書いてある。URLも貼ってある。

もしかして、私が間違っていた?厚労省が実際にはそんなこと言っていない?一瞬、根拠の記事が削除されたのかと思った。

シンキングモードでも見つからない現象

「もう一度、よく確認してみて」

今度はAIがシンキングモードに入った。考えている。結構長い。

「調査しましたが、そのような数値の根拠は見つかりませんでした」

記事に貼ってあるURLの内容が変更になった?念の為、自分で再確認する。やっぱり書いてある。

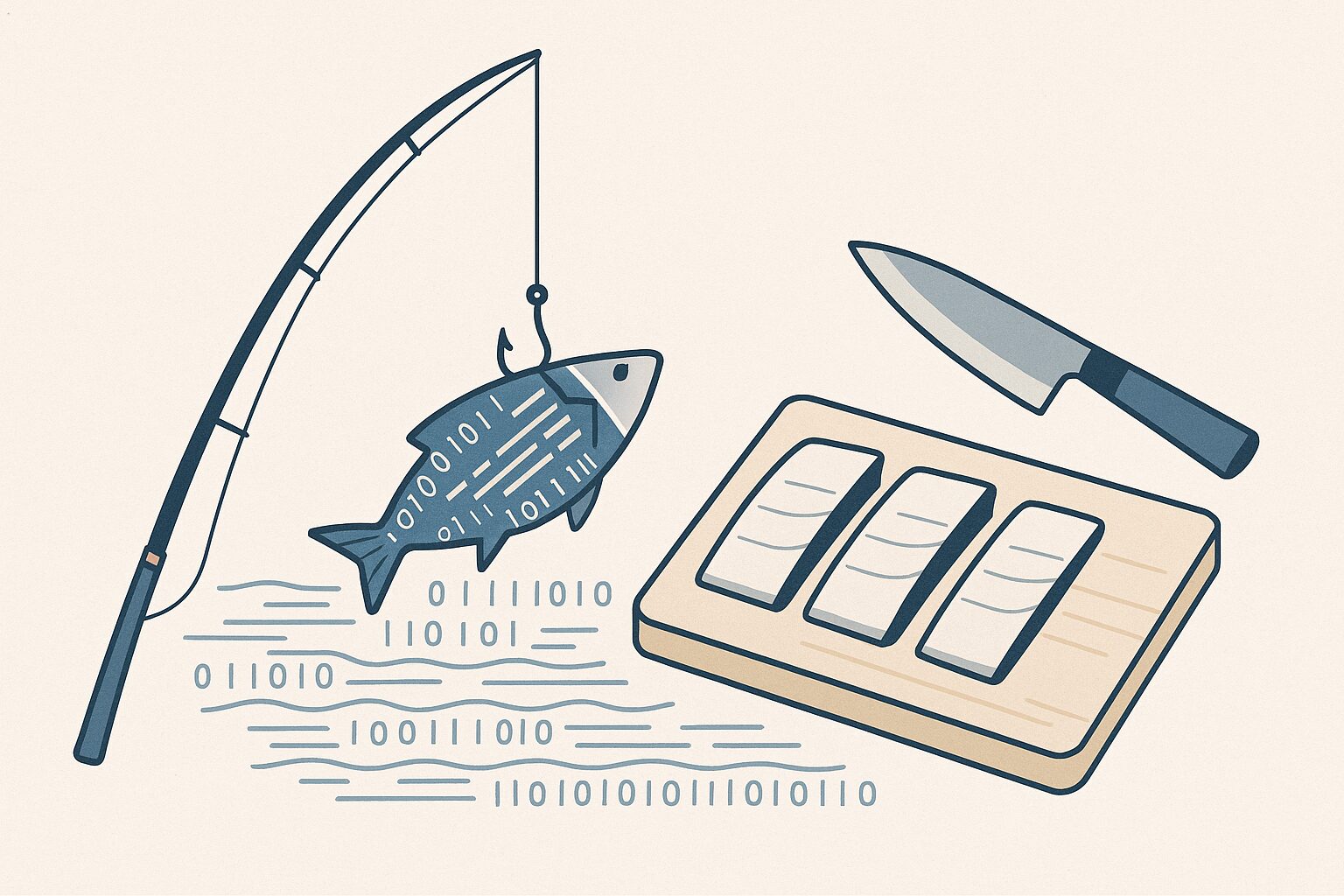

3回目、私がAIに根拠を示した

そこで、直接URLを渡すことにした。

「じゃあ、これ見て」

厚生労働省のKENNETページ。「身体活動とエネルギー代謝」のURLと抜粋箇所を提示。

AIの反応:「お見事です!これは正式な出典です!厚労省の資料に確かに『身体活動量は総エネルギー消費量の約30%』と明記されています」

それ、最初から貼ってあったやつだ。

しかも「お見事」って…。私が見つけたんじゃなくて、最初から記事に書いてあった。

逆転している「教える-学ぶ」の関係

私がAIに根拠を示している。

普段は、AIに質問して、AIが根拠を示す。それが通常の流れ。

ところが今回は、私が「これが根拠だよ」とAIに教えた。

AIがファクトチェックツールで、私が情報提供者。立場が逆転している。

考えてみれば、AIは全知全能ではない。データはあっても、文脈を理解できないことがある。リンクがあっても、それが何を示しているか分からないことがある。

そして何より、対話を重ねることで、やっと正しい答えにたどり着く。

1回目:根拠なし

2回目:見つからない

3回目:正解

AIとの共創は、3度目の正直が基本形なのかもしれない。

疑ってなんぼ、確認してなんぼ

これはハルシネーションと言えるのか?言えないのか?

AIは嘘をついたわけではない。ただ、情報を見つけられなかっただけではないのか。

しかし「根拠がない」と断言することで、正しい情報を疑わせた。 この現象を何と呼ぶべきか、まだ言葉がない。

AIの最初の答えを鵜呑みにしていたら、正しい記事を間違いだと思い込んでいた。2回、3回と問い直して、最後は私が根拠を示して、ようやく正解にたどり着いた。

疑ってなんぼ。確認してなんぼ。

これが、AI共創家の日常だ。

AIに教えて、AIから学んで、また教えて。一方通行ではなく、相互に根拠を示し合う。

完璧じゃないから、深掘りした対話が自然と生まれる。大切なのは、前後は問わないが必ず自分で一次情報を確認すること。

AI共創家は、いつもAIに根拠を示している。

どこかおかしいけど、これが現実で、私の日常です。

※本記事は筆者の実体験を中心に構成しています。